Появились странные дубли страниц

Здравствуйте, очень нужна Ваша помощь. Проблема, в яндекс вебмастере появилось куча дублей страниц, вида

site.ru/?hauth.start=facebook*&hauth.time=<тут цифры>

site.ru/?hauth.start=Google&hauth.time=<тут цифры>

site.ru/?hauth.start=Twitter&hauth.time=<тут цифры>

и т.д для других соц сетей.

Единственный компонент который дает что то похожее, как я понял, это HybridAuth, но для авторизации там ссылки вида ?hauth_action=login&provider=Vkontakte, т.е. не то-же самое.

Код страниц сайта перелопатил, ничего похожего нет. Подскажите откуда взялись и что делать?

site.ru/?hauth.start=facebook*&hauth.time=<тут цифры>

site.ru/?hauth.start=Google&hauth.time=<тут цифры>

site.ru/?hauth.start=Twitter&hauth.time=<тут цифры>

и т.д для других соц сетей.

Единственный компонент который дает что то похожее, как я понял, это HybridAuth, но для авторизации там ссылки вида ?hauth_action=login&provider=Vkontakte, т.е. не то-же самое.

Код страниц сайта перелопатил, ничего похожего нет. Подскажите откуда взялись и что делать?

*Meta, которой принадлежат facebook и instagram признана экстремистской в России

Комментарии: 25

Добавьте в robots.txt строчку

Disallow: *?hauth.start

Здравствуйте. В индекс они не попадают, у меня стоит правило Disallow: /?

Вопрос, раньше их не было, откуда могли появится и как убрать. Ведь так не должно быть, на сайте таких ссылок найти не могу, а Яндекс их где-то нашел и учел.

Вопрос, раньше их не было, откуда могли появится и как убрать. Ведь так не должно быть, на сайте таких ссылок найти не могу, а Яндекс их где-то нашел и учел.

откуда могли появитсяавторизация на сайте через соц сети, например

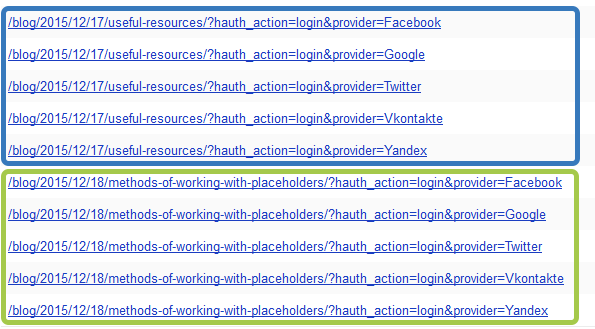

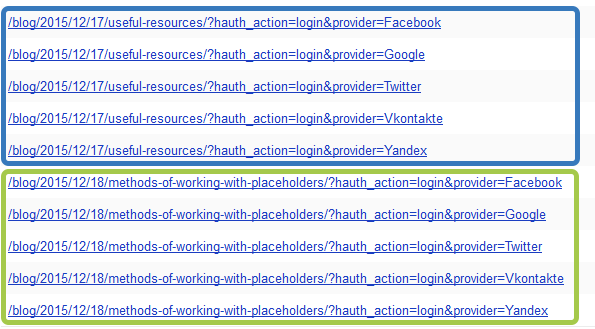

Так и есть, авторизация с помощью HybridAuth, но она есть только на одной странице и ссылки там вида

?hauth_action=login&provider=Vkontakte, а не /?hauth.start=Vkontakte&hauth.time=<тут цифры>

А дубли страниц, даже если они закрыт в robots.txt — зло, особенно если они взялись непонятно откуда

?hauth_action=login&provider=Vkontakte, а не /?hauth.start=Vkontakte&hauth.time=<тут цифры>

А дубли страниц, даже если они закрыт в robots.txt — зло, особенно если они взялись непонятно откуда

Однако, ?hauth.start=[provider]&hauth.time=[timestamp] присутствует на тысячах сайтов. Увы.

Это я уже «лопатил». Но, не было, не было (больше года) и бац, вторая смена — куча дублей (пусть и скрытых в роботс)

А эти дубли ( в вашем случае) проиндексированы Яндексом?

Честно, я бы при наличии rel=«canonical» на всех страницах не парился бы об этих GET-параметрах (это просто мысль вслух, не рекомендация, конечно).

Честно, я бы при наличии rel=«canonical» на всех страницах не парился бы об этих GET-параметрах (это просто мысль вслух, не рекомендация, конечно).

Конечно, может у меня уже и паранойя, есть и rel=«canonical» и настроенный роботс, но как говорится «обжегся на молоке, на воду дую».

На сайте (другом) был компонент — голосовалка со звездами, давала кучу дублей каждой страницы (canonical тоже был), но на сайте, если память не изменяет по проверки xtool.ru, появилась пометка спамности от яндекса. Ну ни как посещалка не шла, убрал «голосовалку», дубли со временем ушли и трафик стал расти. Конечно может и совпадение, а может и нет

На сайте (другом) был компонент — голосовалка со звездами, давала кучу дублей каждой страницы (canonical тоже был), но на сайте, если память не изменяет по проверки xtool.ru, появилась пометка спамности от яндекса. Ну ни как посещалка не шла, убрал «голосовалку», дубли со временем ушли и трафик стал расти. Конечно может и совпадение, а может и нет

Да, понимаю вас. Тоже бьюсь с индексацией.

оффтоп: Кстати, не сочтите за рекламу, ибо не мое, но мне понравился SEOTO.ME — много нашел косяков по их отчетам.

оффтоп: Кстати, не сочтите за рекламу, ибо не мое, но мне понравился SEOTO.ME — много нашел косяков по их отчетам.

Кстати, а может вынести страницу с авторизацией на поддомен?

Интересная идея. У меня авторизация используется только для добавления статей с фронта с помощью tickets, ну очень не хочется заморачиваться с поддоменами, не разу не делал авторизацию с поддомена. Сижу чешу репу — ищу ссылки, прям загадка какае-то, на сайте ссылок я не нашел, а яндекс нашел

Создать поддомен, задать домен для хранения сессии, как бы все.

Вот же, на ЭТОМ сайте, тоже авторизация через поддомен id.modx.pro/sub/login?action=remote/auth

(и послышалось: «верной дорогой идете, товарищи!»)

(и послышалось: «верной дорогой идете, товарищи!»)

Параметр session_cookie_domain = ваш основной домен

(после этого очистить кеш и в браузере тоже, иначе авторизация не удастся)

(после этого очистить кеш и в браузере тоже, иначе авторизация не удастся)

Спасибо, пока не «вкурил», есть где почитать поподробнее, что бы не мучить глупыми вопросами

Вы со мной как со знающим человеком, а я тут туплю, мне нужно разжевать или носом ткнуть :)

Постав заметки

<!--noindex--><!--/!noindex-->

Попробую, но

<!--noindex-->

После этого яндекс перестал индексировать

Обратил внимание. У меня тоже каждую статью Яндекс дублирует

Не понятно как такое получается, но я не парюсь.

Не понятно как такое получается, но я не парюсь.

Про свою паранойю я писал выше. А как у Вас с посещаемостью?

У меня настроено вот так — modx.pro/robots.txt

Вроде всё хорошо.

Вроде всё хорошо.

Спасибо.

Добавил: Clean-param: hauth *

А вот указать более детальную запись Clean-param: hauth.start * дает ошибку, видимо не нравится точка после hauth.

Буду ждать, что покажет Яндекс, борьба за правильную индексацию продолжается

Добавил: Clean-param: hauth *

А вот указать более детальную запись Clean-param: hauth.start * дает ошибку, видимо не нравится точка после hauth.

Буду ждать, что покажет Яндекс, борьба за правильную индексацию продолжается

Ну у тебя не будет таких проблем как у других потому что вход и регистрация у тебя на поддомене.

Вот эту конструкцию:

Disallow: /manager/

Лучше не указывать т.к. она автоматом дает знать, где вход в админку. Достаточно просто робота сделать который обходит сайты и ищет такие функции. Конечно, для хорошо защищенных проектов это не проблема, но для большинства не стоит это указывать.

По этой записи часто проверяют CMS и связывают с modx, после того как известна CMS проще взлом.

Ну это для параноиков))

Disallow: /manager/

Лучше не указывать т.к. она автоматом дает знать, где вход в админку. Достаточно просто робота сделать который обходит сайты и ищет такие функции. Конечно, для хорошо защищенных проектов это не проблема, но для большинства не стоит это указывать.

По этой записи часто проверяют CMS и связывают с modx, после того как известна CMS проще взлом.

Ну это для параноиков))

Авторизуйтесь или зарегистрируйтесь, чтобы оставлять комментарии.